Hoe kan je met tekstanalyse de betrokkenheid van jouw medewerkers meten?

Op basis van interne communicatie de mate van betrokkenheid van medewerkers in kaart brengen. Dat is in één zin samengevat de onderzoeksvraag waar onderzoekers Jeroen Naudts, Els Verzele en Frank D'hanis een antwoord op wilden vinden in het project ‘Glue Factor’. Ze delen hun belangrijkste inzichten rond geautomatiseerde tekstanalyse.

Op basis van interne communicatie – en dan meer specifiek intern mailverkeer tussen medewerkers – de mate van betrokkenheid van medewerkers in kaart brengen. Dat is in één zin samengevat de onderzoeksvraag waar we een antwoord op wilden vinden in ons onderzoek ‘Glue Factor’.

Met veel enthousiasme gingen we met het onderzoeksteam aan de slag, maar al snel ervaarden we: dit wordt geen eenvoudige opdracht. In dit artikel delen we wat we leerden na één onderzoeksjaar over de mogelijkheden (en beperkingen) van de technische kant van tekstanalyse van intern mailverkeer.

Dit zijn de vier belangrijkste deliverables van ons onderzoek:

1. Een duidelijke definitie van betrokkenheid

Wat is betrokkenheid juist? Intuïtief voelen we allemaal wel aan wat het ongeveer betekent. Maar voor een onderzoek met geautomatiseerde tekstanalyse is ongeveer niet voldoende. Gelukkig hadden we de input van onze voorbereidende deskresearch waarin we ons in uitgebreid academisch onderzoek verdiept hadden. Daaruit bleek het onderzoek van Allen en Meyer (1990) nog altijd een heel relevant kader te bieden voor het aflijnen van een definitie voor betrokkenheid.

Alleen hadden we met één factor nog geen rekening gehouden. Aangezien dit onderzoek in het Engels uitgevoerd was en onze tekstanalyse in het Nederlands zou gevoerd worden, zaten we dus met een bijkomende uitdaging.

Gelukkig bracht diepgaander onderzoek ons bij werk van de Nederlandse academici Suzanne Jak en Arne Evers (2010) die van deze lijst een Nederlandse vertaling gemaakt hadden en uitgebreid getest hadden.

Eindelijk hadden we een stabiel vertrekpunt om verder op te bouwen.

Drie componenten van betrokkenheid

Het 3-componentenmodel van betrokkenheid van Allen en Meyer (1990), is het bekendste model op het gebied van organizational commitment.

Jak en Evers (2010) ontwikkelden een Nederlandstalige versie en onderscheiden de affectieve, continuïteits- en normatieve betrokkenheid.

2. Stabiele beslissingsboom om tekstanalyse op te baseren

Om met tekstanalyse aan de slag te gaan, heb je een vast draaiboek nodig dat jouw codeurs telkens opnieuw kunnen gebruiken voor de tekstanalyse. Het opstellen van dat draaiboek vraagt verschillende bijsturingen. We hebben het nageteld: onze beslissingsboom is 7 keer veranderd en aangepast.

Verschillende interpretaties van de definitie betrokkenheid zorgden voor steeds meer verschillende invalshoeken voor onze beslissingsboom. In het beginstadium experimenteerden we met alle mogelijke structuren om uiteindelijk tot een meer waterdichte beslissingsboom te komen.

Lesson learned: sneller tot de toepassing overgaan en dus de beslissingsboom testen in de praktijk en niet al te lang blijven hangen bij soms bijna filosofische gesprekken over betekenissen van woorden. Een goede balans tussen denken en doen zou ons allicht sneller vooruitgeholpen helpen. Maar de discussies waren de moeite waard, alleen al omdat we later in het proces sneller konden beslissen.

Het is dan ook grappig dat we met een ‘klein hartje’ de eerste structurele testing met studenten ingingen omdat we dachten dat de beslissingsboom enorm complex geworden was. Maar die vrees leek helemaal onterecht. Want wat bleek? Op nog geen half uur was de volledige beslissingsboom uitgelegd en bleek uit enkele tests dat de studenten dit heel snel begrepen hadden én dit ook erg accuraat toepasten.

Nog één straffe afsluiter? Na uitgebreid te testen, bevestigden de studenten een aantal van onze veronderstellingen. We speelden met de idee om de beslissingsboom nog te vereenvoudigen, maar zouden eerst de test met de studenten afwachten om nog maar eens tot een aanpassing over te gaan. De test met de studenten heeft de definitieve structuur van de beslissingsboom nog verder vereenvoudigd. Nu wordt hij ongetwijfeld nog eenvoudiger om uit te leggen.

Benieuwd naar die beslissingsboom?

In deze blogpost lees je de korte samenvatting van het proces. Wil je het proces meer in detail lezen? Lees dan zeker onze uitgebreide blogpost over hoe de beslissingsboom tot stand kwam.

3. Inzicht in annotatietool INCEpTION

Tekst analyseren: zo complex kan dat toch nog niet zijn? Toegegeven, dat dachten wij vooraf ook wel een beetje. We konden nier meer fout zijn…

Nog voor we de eigenlijke tekstanalyse via Python konden doen, was het in deze eerste exploratiefase noodzakelijk dat we manueel de onderdelen van zinnen gingen benoemen die op betrokkenheid duiden. Dat kan je niet zomaar in dataverwerkingssoftware R of Python doen.

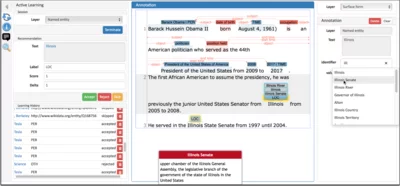

Na ons voorbereidend onderzoek bleek de annotatietool INCEpTION ideaal te zijn voor wat wij nodig hadden. Dat hoeft niet te betekenen dat dit dé perfecte tool is; ook andere tools kunnen hiervoor erg waardevol zijn.

Screenshot van de semantische annotatietool INCEpTION (Klie et al., 2018)

4. De eerste (voorzichtige) resultaten

Ook wat het programmeren betrof, bleek een initieel makkelijk lijkende opdracht, namelijk “laat een AI-model teksten analyseren op betrokkenheid”, tijdens het onderzoeksproces steeds complexer en te leiden tot steeds meer vragen.

Vragen als: welk AI-model gebruiken we, welke AI-functie van NLP voert het model uit, hoe operationaliseren we betrokkenheid, hoe coderen we die operationalisering, welke software en infrastructuur hebben we hiervoor nodig, welke tools? Bij elk antwoord dat we hierop formuleerden leek er zich een wereld aan nieuwe vragen te openen.

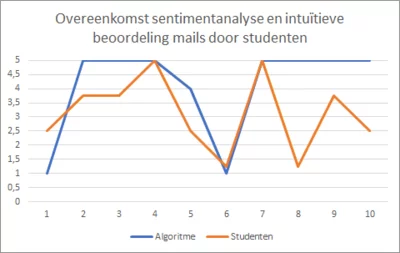

Ondanks al deze uitdagingen konden we op het einde van onze eerste onderzoeksjaar een eerste keer een ‘multilinguale’ (dus strikt genomen geen Nederlandstalige) versie van BERT (ons AI-model) loslaten op een twintigtal mails die onze studenten intuïtief op betrokkenheid beoordeeld hadden. Het ging hier over een sentimentanalyse, een tool die in een pipeline van BERT zit, en waar we met andere woorden dus nog niet zo veel eigen programmeerwerk in hoefden te steken (ook al is dat relatief).

Uit deze eerste tentatieve analyse bleek dat de intuïtieve inzichten van één van de groepen studenten in acht van de tien gevallen in dezelfde richting scoorden. Dit is toch wel een opmerkelijk resultaat voor een beoordelingsproces dat door zijn intuïtieve aard (spontaan bij de studenten) niet naar een consistente geoperationaliseerde notie van betrokkenheid gestuurd werd (aangezien we de tool van BERT gebruikten, zonder veel eigen aanpassingen).

Plannen voor jaar 2 van het onderzoeksproject

Deze bevindingen geven ons vertrouwen voor de volgende stappen in dit onderzoeksjaar:

1. De betrouwbaarheid van de vermelde analyse was slechts 47 procent. We willen dit minstens naar 80 procent brengen.

2. We willen onze eigen definitie van betrokkenheid operationaliseren en bekijken hoe BERT onze manuele annotaties kan dupliceren (of dit niet kan). Hiervoor zal een finetuning van BERT nodig zijn en moeten we naast Wikipedia ook een andere library gebruiken die qua teksttypes meer overeenkomt met het mail-formaat. Deze extra vergelijkingsbron zou de betrouwbaarheid ook moeten verhogen.

3. We willen dit met een groot aantal mails doen, meer in de orde van grootheid van 500 à 1000 en hier dan een statistische analyse op toepassen.

Meer weten?

Hopelijk kunnen onze inzichten jou helpen als je een soortgelijk onderzoek wilt doen. Veel succes!

Heb je vragen? Aarzel niet om ons te contacteren!

Je kan onze website bekijken, of een mailtje sturen naar projectleider Jeroen Naudts.

Bronnen

- Allen, Natalie J., & Meyer, John P. (1990). The measurement and antecedents of affective, continuance and normative commitment to the organization. Journal of occupational psychology, 63(1), 1-18. https://doi.org/10.1111/j.2044-8325.1990.tb00506.x

- Jak, Suzanne, & Evers, Arne (2010). Onderzoeksnotitie: Een vernieuwd meetinstrument voor organizational commitment. Gedrag & Organisatie, 23(2). https://doi.org/10.5117/2010.023.002.004

- Klie, J.-C., Bugert, M., Boullosa, B., Eckart de Castilho, R. and Gurevych, I. (2018). The INCEpTION platform: machine-assisted and knowledge-oriented interactive annotation. In Proceedings of System Demonstrations of the 27th International Conference on Computational Linguistics (COLING 2018), Santa Fe, New Mexico, USA. https://aclanthology.org/C18-2002

- Naudts, Jeroen, Verzele, Els, & D’hanis, Frank (2022). The Glue Factor: betrokkenheid van medewerkers meten op basis van tekstanalyse [Projectfiche]. Arteveldehogeschool. https://www.arteveldehogeschool.be/gluefactor

- Naudts, Jeroen, Verzele, Els, & D’hanis, Frank (2022, 5 oktober). De weg naar een codeboek. Een stabiele beslissingsboom om de tekstanalyse op te baseren [blogpost]. Arteveldehogeschool. https://blog.arteveldehogeschool.be/een-stabiele-beslissingsboom-om-de-tekstanalyse-op-te-baseren/

Lees ook

Klinisch leiderschap: ‘Nice to have’ of pure noodzaak?

Door de hervorming van de klinische ladder en de veranderende verantwoordelijkheden binnen verschillende functieprofielen, zijn leiderschapsvaardigheden bij zorgverleners van groot belang. Maar wat maakt klinisch leiderschap zo essentieel? En welke eigenschappen hebben zorgverleners nodig om de uitdagingen van het zorglandschap het hoofd te bieden?

Inclusief digitaal actief: een inspiratiedag vanuit PWO project ‘Digi Act'

Op 22 februari 2024 kwamen meer dan 120 sociale professionals en hulpverleners samen rond de thema’s “het bevorderen van digitale inclusie voor mensen met een beperking & digitale dagbesteding”. Deze bijeenkomst, georganiseerd door de expertiselijn “Mens, Samenleving en Digitalisering”, zette het resultaat van anderhalf jaar onderzoek in de kijker.

Het leven zoals het is: inspirerend coach

Trainer Anne Breda blikt terug op een intervisie inspirerend coachen door en voor mensen uit de zorgsector. Een groepje van acht denkt drie uur lang samen na met GRROW als ruggengraat. De conclusie? Dat deze manier van werken toch erg waardevol blijkt.

First time voter? 5 tips om niet te verdrinken in de verkiezingsstorm.

De politieke campagnes ons om de oren. Met deze 5 tips kunnen de 500.000 first time voters met meer zelfvertrouwen het verkiezingsjaar induiken.